處理遺失資料#

被視為「遺失」的值#

pandas 使用不同的哨兵值來表示遺失(也稱為 NA),具體取決於資料類型。

numpy.nan 適用於 NumPy 資料類型。使用 NumPy 資料類型的缺點是原始資料類型會強制轉換為 np.float64 或 object。

In [1]: pd.Series([1, 2], dtype=np.int64).reindex([0, 1, 2])

Out[1]:

0 1.0

1 2.0

2 NaN

dtype: float64

In [2]: pd.Series([True, False], dtype=np.bool_).reindex([0, 1, 2])

Out[2]:

0 True

1 False

2 NaN

dtype: object

NaT 適用於 NumPy np.datetime64、np.timedelta64 以及 PeriodDtype。對於輸入應用程式,請使用 api.types.NaTType。

In [3]: pd.Series([1, 2], dtype=np.dtype("timedelta64[ns]")).reindex([0, 1, 2])

Out[3]:

0 0 days 00:00:00.000000001

1 0 days 00:00:00.000000002

2 NaT

dtype: timedelta64[ns]

In [4]: pd.Series([1, 2], dtype=np.dtype("datetime64[ns]")).reindex([0, 1, 2])

Out[4]:

0 1970-01-01 00:00:00.000000001

1 1970-01-01 00:00:00.000000002

2 NaT

dtype: datetime64[ns]

In [5]: pd.Series(["2020", "2020"], dtype=pd.PeriodDtype("D")).reindex([0, 1, 2])

Out[5]:

0 2020-01-01

1 2020-01-01

2 NaT

dtype: period[D]

NA 適用於 StringDtype、Int64Dtype(以及其他位元寬度)、Float64Dtype(以及其他位元寬度)、:class:`BooleanDtype 以及 ArrowDtype。這些類型會維護資料的原始資料類型。對於輸入應用程式,請使用 api.types.NAType。

In [6]: pd.Series([1, 2], dtype="Int64").reindex([0, 1, 2])

Out[6]:

0 1

1 2

2 <NA>

dtype: Int64

In [7]: pd.Series([True, False], dtype="boolean[pyarrow]").reindex([0, 1, 2])

Out[7]:

0 True

1 False

2 <NA>

dtype: bool[pyarrow]

若要偵測這些遺失值,請使用 isna() 或 notna() 方法。

In [8]: ser = pd.Series([pd.Timestamp("2020-01-01"), pd.NaT])

In [9]: ser

Out[9]:

0 2020-01-01

1 NaT

dtype: datetime64[ns]

In [10]: pd.isna(ser)

Out[10]:

0 False

1 True

dtype: bool

注意

isna() 或 notna() 也會將 None 視為遺失值。

In [11]: ser = pd.Series([1, None], dtype=object)

In [12]: ser

Out[12]:

0 1

1 None

dtype: object

In [13]: pd.isna(ser)

Out[13]:

0 False

1 True

dtype: bool

警告

在 np.nan、NaT 和 NA 之間的等式比較並不作用於 None

In [14]: None == None # noqa: E711

Out[14]: True

In [15]: np.nan == np.nan

Out[15]: False

In [16]: pd.NaT == pd.NaT

Out[16]: False

In [17]: pd.NA == pd.NA

Out[17]: <NA>

因此,DataFrame 或 Series 與這些遺失值之一之間的等式比較,並未提供與 isna() 或 notna() 相同的資訊。

In [18]: ser = pd.Series([True, None], dtype="boolean[pyarrow]")

In [19]: ser == pd.NA

Out[19]:

0 <NA>

1 <NA>

dtype: bool[pyarrow]

In [20]: pd.isna(ser)

Out[20]:

0 False

1 True

dtype: bool

NA 語意#

警告

實驗性:NA` 的行為仍可能在未警告的情況下改變。

從 pandas 1.0 開始,一個實驗性的 NA 值(單例)可用於表示純量遺失值。 NA 的目標是提供一個「遺失」指標,可在所有資料類型中一致使用(而不是 np.nan、None 或 pd.NaT,視資料類型而定)。

例如,當 Series 中有遺失值,且具有可為空整數資料類型時,它將使用 NA。

In [21]: s = pd.Series([1, 2, None], dtype="Int64")

In [22]: s

Out[22]:

0 1

1 2

2 <NA>

dtype: Int64

In [23]: s[2]

Out[23]: <NA>

In [24]: s[2] is pd.NA

Out[24]: True

目前,pandas 尚未使用 NA 的資料類型,預設為 DataFrame 或 Series,因此您需要明確指定資料類型。在 轉換區段 中說明了轉換為這些資料類型的簡單方法。

算術和比較運算中的傳播#

一般而言,在涉及 NA 的運算中,遺失值會傳播。當其中一個運算元未知時,運算結果也會未知。

例如,NA 會在算術運算中傳播,類似於 np.nan

In [25]: pd.NA + 1

Out[25]: <NA>

In [26]: "a" * pd.NA

Out[26]: <NA>

在某些特殊情況下,即使其中一個運算元為 NA,結果也是已知的。

In [27]: pd.NA ** 0

Out[27]: 1

In [28]: 1 ** pd.NA

Out[28]: 1

在等式和比較運算中,NA 也會傳播。這與 np.nan 的行為不同,其中與 np.nan 的比較總是傳回 False。

In [29]: pd.NA == 1

Out[29]: <NA>

In [30]: pd.NA == pd.NA

Out[30]: <NA>

In [31]: pd.NA < 2.5

Out[31]: <NA>

In [32]: pd.isna(pd.NA)

Out[32]: True

注意

此基本傳播規則的例外情況是簡約(例如平均值或最小值),其中 pandas 預設會略過遺失值。請參閱 計算部分 以取得更多資訊。

邏輯運算#

對於邏輯運算,NA 遵循 三值邏輯(或稱為 Kleene 邏輯,類似於 R、SQL 和 Julia)的規則。此邏輯表示僅在邏輯上需要時才傳遞遺失值。

例如,對於邏輯「或」運算 (|),如果其中一個運算元為 True,我們已經知道結果將為 True,而與另一個值無關(因此遺失值將為 True 或 False)。在這種情況下,NA 不會傳遞

In [33]: True | False

Out[33]: True

In [34]: True | pd.NA

Out[34]: True

In [35]: pd.NA | True

Out[35]: True

另一方面,如果其中一個運算元為 False,則結果取決於另一個運算元的值。因此,在這種情況下,NA 會傳遞

In [36]: False | True

Out[36]: True

In [37]: False | False

Out[37]: False

In [38]: False | pd.NA

Out[38]: <NA>

邏輯「與」運算 (&) 的行為可以使用類似的邏輯來推導(其中現在 NA 如果其中一個運算元已經是 False),則不會傳播)

In [39]: False & True

Out[39]: False

In [40]: False & False

Out[40]: False

In [41]: False & pd.NA

Out[41]: False

In [42]: True & True

Out[42]: True

In [43]: True & False

Out[43]: False

In [44]: True & pd.NA

Out[44]: <NA>

NA 在布林文中#

由於 NA 的實際值未知,因此將 NA 轉換為布林值是模稜兩可的。

In [45]: bool(pd.NA)

---------------------------------------------------------------------------

TypeError Traceback (most recent call last)

Cell In[45], line 1

----> 1 bool(pd.NA)

File missing.pyx:392, in pandas._libs.missing.NAType.__bool__()

TypeError: boolean value of NA is ambiguous

這也表示 NA 無法用於評估為布林值的情境中,例如 if condition: ...,其中 condition 可能會是 NA。在這種情況下,可以使用 isna() 來檢查 NA 或避免 condition 為 NA,例如事先填入遺失值。

在 if 陳述式中使用 Series 或 DataFrame 物件時,會發生類似的情況,請參閱 在 pandas 中使用 if/真值陳述式。

NumPy ufuncs#

pandas.NA 實作 NumPy 的 __array_ufunc__ 協定。大多數 ufunc 都適用於 NA,且通常會傳回 NA

In [46]: np.log(pd.NA)

Out[46]: <NA>

In [47]: np.add(pd.NA, 1)

Out[47]: <NA>

警告

目前,包含 ndarray 和 NA 的 ufunc 會傳回填滿 NA 值的物件資料型別。

In [48]: a = np.array([1, 2, 3])

In [49]: np.greater(a, pd.NA)

Out[49]: array([<NA>, <NA>, <NA>], dtype=object)

此處的傳回類型未來可能會變更為傳回不同的陣列類型。

請參閱 DataFrame 與 NumPy 函數的互通性 以進一步瞭解 ufunc。

轉換#

如果您有 DataFrame 或 Series 使用 np.nan,Series.convert_dtypes() 和 DataFrame.convert_dtypes() 在 DataFrame 中,它可以將資料轉換為使用資料類型的 NA,例如 Int64Dtype 或 ArrowDtype。這在從資料類型推斷的 IO 方法中讀取資料集後特別有幫助。

在此範例中,雖然所有欄位的資料類型都已變更,但我們顯示前 10 個欄位的結果。

In [50]: import io

In [51]: data = io.StringIO("a,b\n,True\n2,")

In [52]: df = pd.read_csv(data)

In [53]: df.dtypes

Out[53]:

a float64

b object

dtype: object

In [54]: df_conv = df.convert_dtypes()

In [55]: df_conv

Out[55]:

a b

0 <NA> True

1 2 <NA>

In [56]: df_conv.dtypes

Out[56]:

a Int64

b boolean

dtype: object

插入遺失資料#

您可以透過指定 Series 或 DataFrame 來插入遺失值。將根據資料類型選擇使用的遺失值哨兵。

In [57]: ser = pd.Series([1., 2., 3.])

In [58]: ser.loc[0] = None

In [59]: ser

Out[59]:

0 NaN

1 2.0

2 3.0

dtype: float64

In [60]: ser = pd.Series([pd.Timestamp("2021"), pd.Timestamp("2021")])

In [61]: ser.iloc[0] = np.nan

In [62]: ser

Out[62]:

0 NaT

1 2021-01-01

dtype: datetime64[ns]

In [63]: ser = pd.Series([True, False], dtype="boolean[pyarrow]")

In [64]: ser.iloc[0] = None

In [65]: ser

Out[65]:

0 <NA>

1 False

dtype: bool[pyarrow]

對於 object 類型,pandas 會使用給定的值

In [66]: s = pd.Series(["a", "b", "c"], dtype=object)

In [67]: s.loc[0] = None

In [68]: s.loc[1] = np.nan

In [69]: s

Out[69]:

0 None

1 NaN

2 c

dtype: object

遺失資料的計算#

遺失值會透過 pandas 物件之間的算術運算傳播。

In [70]: ser1 = pd.Series([np.nan, np.nan, 2, 3])

In [71]: ser2 = pd.Series([np.nan, 1, np.nan, 4])

In [72]: ser1

Out[72]:

0 NaN

1 NaN

2 2.0

3 3.0

dtype: float64

In [73]: ser2

Out[73]:

0 NaN

1 1.0

2 NaN

3 4.0

dtype: float64

In [74]: ser1 + ser2

Out[74]:

0 NaN

1 NaN

2 NaN

3 7.0

dtype: float64

在 資料結構概觀 中討論的描述性統計和計算方法(並在 這裡 和 這裡 列出)都說明了遺失資料。

在對資料求和時,NA 值或空資料將視為零。

In [75]: pd.Series([np.nan]).sum()

Out[75]: 0.0

In [76]: pd.Series([], dtype="float64").sum()

Out[76]: 0.0

在取乘積時,NA 值或空資料將視為 1。

In [77]: pd.Series([np.nan]).prod()

Out[77]: 1.0

In [78]: pd.Series([], dtype="float64").prod()

Out[78]: 1.0

預設情況下,cumsum() 和 cumprod() 等累積方法會忽略 NA 值,並將其保留在結果中。此行為可以使用 skipna 進行變更

In [79]: ser = pd.Series([1, np.nan, 3, np.nan])

In [80]: ser

Out[80]:

0 1.0

1 NaN

2 3.0

3 NaN

dtype: float64

In [81]: ser.cumsum()

Out[81]:

0 1.0

1 NaN

2 4.0

3 NaN

dtype: float64

In [82]: ser.cumsum(skipna=False)

Out[82]:

0 1.0

1 NaN

2 NaN

3 NaN

dtype: float64

刪除遺失資料#

dropna() 刪除有遺失資料的列或欄。

In [83]: df = pd.DataFrame([[np.nan, 1, 2], [1, 2, np.nan], [1, 2, 3]])

In [84]: df

Out[84]:

0 1 2

0 NaN 1 2.0

1 1.0 2 NaN

2 1.0 2 3.0

In [85]: df.dropna()

Out[85]:

0 1 2

2 1.0 2 3.0

In [86]: df.dropna(axis=1)

Out[86]:

1

0 1

1 2

2 2

In [87]: ser = pd.Series([1, pd.NA], dtype="int64[pyarrow]")

In [88]: ser.dropna()

Out[88]:

0 1

dtype: int64[pyarrow]

填補遺失資料#

依值填補#

fillna() 以非 NA 資料取代 NA 值。

以純量值取代 NA

In [89]: data = {"np": [1.0, np.nan, np.nan, 2], "arrow": pd.array([1.0, pd.NA, pd.NA, 2], dtype="float64[pyarrow]")}

In [90]: df = pd.DataFrame(data)

In [91]: df

Out[91]:

np arrow

0 1.0 1.0

1 NaN <NA>

2 NaN <NA>

3 2.0 2.0

In [92]: df.fillna(0)

Out[92]:

np arrow

0 1.0 1.0

1 0.0 0.0

2 0.0 0.0

3 2.0 2.0

向前或向後填補間隙

In [93]: df.ffill()

Out[93]:

np arrow

0 1.0 1.0

1 1.0 1.0

2 1.0 1.0

3 2.0 2.0

In [94]: df.bfill()

Out[94]:

np arrow

0 1.0 1.0

1 2.0 2.0

2 2.0 2.0

3 2.0 2.0

限制填補的 NA 值數量

In [95]: df.ffill(limit=1)

Out[95]:

np arrow

0 1.0 1.0

1 1.0 1.0

2 NaN <NA>

3 2.0 2.0

NA 值可以用 Series 或 DataFrame 中對應的值取代,其中索引和欄位與原始物件和填入物件對齊。

In [96]: dff = pd.DataFrame(np.arange(30, dtype=np.float64).reshape(10, 3), columns=list("ABC"))

In [97]: dff.iloc[3:5, 0] = np.nan

In [98]: dff.iloc[4:6, 1] = np.nan

In [99]: dff.iloc[5:8, 2] = np.nan

In [100]: dff

Out[100]:

A B C

0 0.0 1.0 2.0

1 3.0 4.0 5.0

2 6.0 7.0 8.0

3 NaN 10.0 11.0

4 NaN NaN 14.0

5 15.0 NaN NaN

6 18.0 19.0 NaN

7 21.0 22.0 NaN

8 24.0 25.0 26.0

9 27.0 28.0 29.0

In [101]: dff.fillna(dff.mean())

Out[101]:

A B C

0 0.00 1.0 2.000000

1 3.00 4.0 5.000000

2 6.00 7.0 8.000000

3 14.25 10.0 11.000000

4 14.25 14.5 14.000000

5 15.00 14.5 13.571429

6 18.00 19.0 13.571429

7 21.00 22.0 13.571429

8 24.00 25.0 26.000000

9 27.00 28.0 29.000000

注意

DataFrame.where() 也可用來填入 NA 值。結果與上述相同。

In [102]: dff.where(pd.notna(dff), dff.mean(), axis="columns")

Out[102]:

A B C

0 0.00 1.0 2.000000

1 3.00 4.0 5.000000

2 6.00 7.0 8.000000

3 14.25 10.0 11.000000

4 14.25 14.5 14.000000

5 15.00 14.5 13.571429

6 18.00 19.0 13.571429

7 21.00 22.0 13.571429

8 24.00 25.0 26.000000

9 27.00 28.0 29.000000

內插#

DataFrame.interpolate() 和 Series.interpolate() 使用各種內插方法填入 NA 值。

In [103]: df = pd.DataFrame(

.....: {

.....: "A": [1, 2.1, np.nan, 4.7, 5.6, 6.8],

.....: "B": [0.25, np.nan, np.nan, 4, 12.2, 14.4],

.....: }

.....: )

.....:

In [104]: df

Out[104]:

A B

0 1.0 0.25

1 2.1 NaN

2 NaN NaN

3 4.7 4.00

4 5.6 12.20

5 6.8 14.40

In [105]: df.interpolate()

Out[105]:

A B

0 1.0 0.25

1 2.1 1.50

2 3.4 2.75

3 4.7 4.00

4 5.6 12.20

5 6.8 14.40

In [106]: idx = pd.date_range("2020-01-01", periods=10, freq="D")

In [107]: data = np.random.default_rng(2).integers(0, 10, 10).astype(np.float64)

In [108]: ts = pd.Series(data, index=idx)

In [109]: ts.iloc[[1, 2, 5, 6, 9]] = np.nan

In [110]: ts

Out[110]:

2020-01-01 8.0

2020-01-02 NaN

2020-01-03 NaN

2020-01-04 2.0

2020-01-05 4.0

2020-01-06 NaN

2020-01-07 NaN

2020-01-08 0.0

2020-01-09 3.0

2020-01-10 NaN

Freq: D, dtype: float64

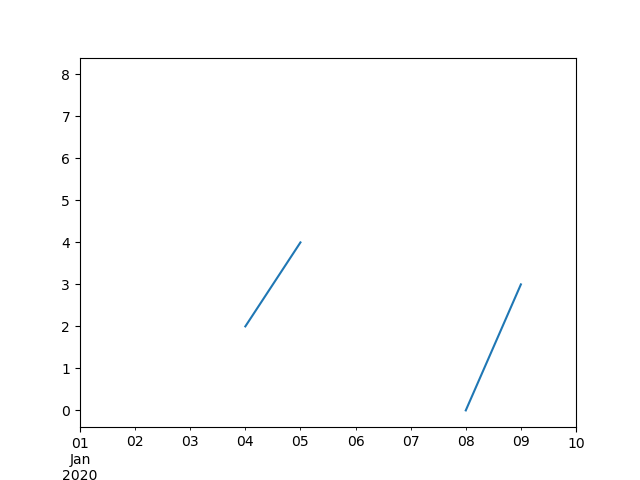

In [111]: ts.plot()

Out[111]: <Axes: >

In [112]: ts.interpolate()

Out[112]:

2020-01-01 8.000000

2020-01-02 6.000000

2020-01-03 4.000000

2020-01-04 2.000000

2020-01-05 4.000000

2020-01-06 2.666667

2020-01-07 1.333333

2020-01-08 0.000000

2020-01-09 3.000000

2020-01-10 3.000000

Freq: D, dtype: float64

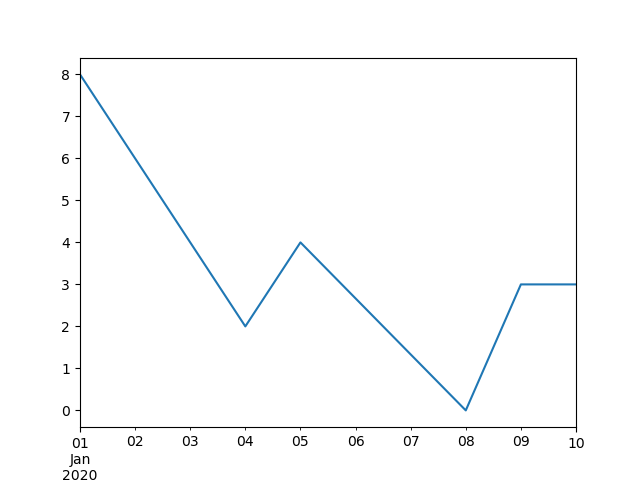

In [113]: ts.interpolate().plot()

Out[113]: <Axes: >

相對於 Timestamp 在 DatetimeIndex 中的內插,可透過設定 method="time"

In [114]: ts2 = ts.iloc[[0, 1, 3, 7, 9]]

In [115]: ts2

Out[115]:

2020-01-01 8.0

2020-01-02 NaN

2020-01-04 2.0

2020-01-08 0.0

2020-01-10 NaN

dtype: float64

In [116]: ts2.interpolate()

Out[116]:

2020-01-01 8.0

2020-01-02 5.0

2020-01-04 2.0

2020-01-08 0.0

2020-01-10 0.0

dtype: float64

In [117]: ts2.interpolate(method="time")

Out[117]:

2020-01-01 8.0

2020-01-02 6.0

2020-01-04 2.0

2020-01-08 0.0

2020-01-10 0.0

dtype: float64

對於浮點數索引,請使用 method='values'

In [118]: idx = [0.0, 1.0, 10.0]

In [119]: ser = pd.Series([0.0, np.nan, 10.0], idx)

In [120]: ser

Out[120]:

0.0 0.0

1.0 NaN

10.0 10.0

dtype: float64

In [121]: ser.interpolate()

Out[121]:

0.0 0.0

1.0 5.0

10.0 10.0

dtype: float64

In [122]: ser.interpolate(method="values")

Out[122]:

0.0 0.0

1.0 1.0

10.0 10.0

dtype: float64

如果您已安裝 scipy,您可以傳遞 1-d 內插常式的名稱給 method。如 scipy 內插 文件 和參考 指南 中所指定。適當的內插方法會根據資料類型而定。

提示

如果您處理的是以越來越快的速度增長的時序,請使用 method='barycentric'。

如果您有近似累積分配函數的值,請使用 method='pchip'。

若要填入遺失值以達到平滑繪製圖表的目的,請使用 method='akima'。

In [123]: df = pd.DataFrame(

.....: {

.....: "A": [1, 2.1, np.nan, 4.7, 5.6, 6.8],

.....: "B": [0.25, np.nan, np.nan, 4, 12.2, 14.4],

.....: }

.....: )

.....:

In [124]: df

Out[124]:

A B

0 1.0 0.25

1 2.1 NaN

2 NaN NaN

3 4.7 4.00

4 5.6 12.20

5 6.8 14.40

In [125]: df.interpolate(method="barycentric")

Out[125]:

A B

0 1.00 0.250

1 2.10 -7.660

2 3.53 -4.515

3 4.70 4.000

4 5.60 12.200

5 6.80 14.400

In [126]: df.interpolate(method="pchip")

Out[126]:

A B

0 1.00000 0.250000

1 2.10000 0.672808

2 3.43454 1.928950

3 4.70000 4.000000

4 5.60000 12.200000

5 6.80000 14.400000

In [127]: df.interpolate(method="akima")

Out[127]:

A B

0 1.000000 0.250000

1 2.100000 -0.873316

2 3.406667 0.320034

3 4.700000 4.000000

4 5.600000 12.200000

5 6.800000 14.400000

透過多項式或樣條近似進行內插時,您還必須指定近似的次數或階數

In [128]: df.interpolate(method="spline", order=2)

Out[128]:

A B

0 1.000000 0.250000

1 2.100000 -0.428598

2 3.404545 1.206900

3 4.700000 4.000000

4 5.600000 12.200000

5 6.800000 14.400000

In [129]: df.interpolate(method="polynomial", order=2)

Out[129]:

A B

0 1.000000 0.250000

1 2.100000 -2.703846

2 3.451351 -1.453846

3 4.700000 4.000000

4 5.600000 12.200000

5 6.800000 14.400000

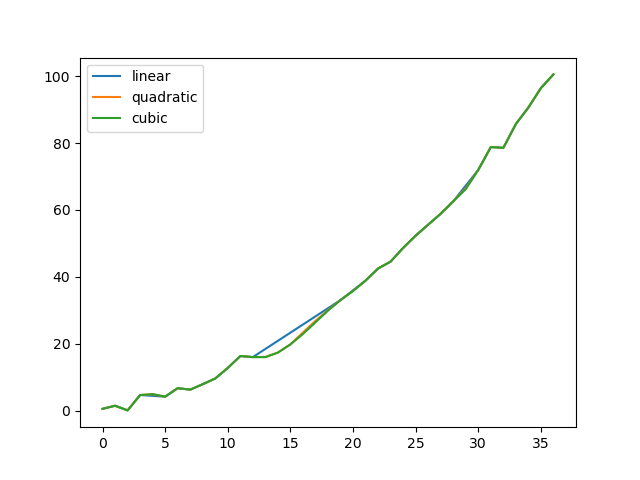

比較多種方法。

In [130]: np.random.seed(2)

In [131]: ser = pd.Series(np.arange(1, 10.1, 0.25) ** 2 + np.random.randn(37))

In [132]: missing = np.array([4, 13, 14, 15, 16, 17, 18, 20, 29])

In [133]: ser.iloc[missing] = np.nan

In [134]: methods = ["linear", "quadratic", "cubic"]

In [135]: df = pd.DataFrame({m: ser.interpolate(method=m) for m in methods})

In [136]: df.plot()

Out[136]: <Axes: >

使用 Series.reindex() 從擴充資料內插新的觀察值。

In [137]: ser = pd.Series(np.sort(np.random.uniform(size=100)))

# interpolate at new_index

In [138]: new_index = ser.index.union(pd.Index([49.25, 49.5, 49.75, 50.25, 50.5, 50.75]))

In [139]: interp_s = ser.reindex(new_index).interpolate(method="pchip")

In [140]: interp_s.loc[49:51]

Out[140]:

49.00 0.471410

49.25 0.476841

49.50 0.481780

49.75 0.485998

50.00 0.489266

50.25 0.491814

50.50 0.493995

50.75 0.495763

51.00 0.497074

dtype: float64

內插限制#

interpolate() 接受 limit 關鍵字參數,以限制自上次有效觀察以來填入的連續 NaN 值數量

In [141]: ser = pd.Series([np.nan, np.nan, 5, np.nan, np.nan, np.nan, 13, np.nan, np.nan])

In [142]: ser

Out[142]:

0 NaN

1 NaN

2 5.0

3 NaN

4 NaN

5 NaN

6 13.0

7 NaN

8 NaN

dtype: float64

In [143]: ser.interpolate()

Out[143]:

0 NaN

1 NaN

2 5.0

3 7.0

4 9.0

5 11.0

6 13.0

7 13.0

8 13.0

dtype: float64

In [144]: ser.interpolate(limit=1)

Out[144]:

0 NaN

1 NaN

2 5.0

3 7.0

4 NaN

5 NaN

6 13.0

7 13.0

8 NaN

dtype: float64

預設情況下,NaN 值會以 forward 方向填入。使用 limit_direction 參數以 backward 或 both 方向填入。

In [145]: ser.interpolate(limit=1, limit_direction="backward")

Out[145]:

0 NaN

1 5.0

2 5.0

3 NaN

4 NaN

5 11.0

6 13.0

7 NaN

8 NaN

dtype: float64

In [146]: ser.interpolate(limit=1, limit_direction="both")

Out[146]:

0 NaN

1 5.0

2 5.0

3 7.0

4 NaN

5 11.0

6 13.0

7 13.0

8 NaN

dtype: float64

In [147]: ser.interpolate(limit_direction="both")

Out[147]:

0 5.0

1 5.0

2 5.0

3 7.0

4 9.0

5 11.0

6 13.0

7 13.0

8 13.0

dtype: float64

預設情況下,NaN 值會填入,無論它們是由現有的有效值包圍,還是位於現有有效值之外。limit_area 參數將填入限制在值內部或外部。

# fill one consecutive inside value in both directions

In [148]: ser.interpolate(limit_direction="both", limit_area="inside", limit=1)

Out[148]:

0 NaN

1 NaN

2 5.0

3 7.0

4 NaN

5 11.0

6 13.0

7 NaN

8 NaN

dtype: float64

# fill all consecutive outside values backward

In [149]: ser.interpolate(limit_direction="backward", limit_area="outside")

Out[149]:

0 5.0

1 5.0

2 5.0

3 NaN

4 NaN

5 NaN

6 13.0

7 NaN

8 NaN

dtype: float64

# fill all consecutive outside values in both directions

In [150]: ser.interpolate(limit_direction="both", limit_area="outside")

Out[150]:

0 5.0

1 5.0

2 5.0

3 NaN

4 NaN

5 NaN

6 13.0

7 13.0

8 13.0

dtype: float64

替換值#

Series.replace() 和 DataFrame.replace() 可類似於 Series.fillna() 和 DataFrame.fillna() 來替換或插入遺失值。

In [151]: df = pd.DataFrame(np.eye(3))

In [152]: df

Out[152]:

0 1 2

0 1.0 0.0 0.0

1 0.0 1.0 0.0

2 0.0 0.0 1.0

In [153]: df_missing = df.replace(0, np.nan)

In [154]: df_missing

Out[154]:

0 1 2

0 1.0 NaN NaN

1 NaN 1.0 NaN

2 NaN NaN 1.0

In [155]: df_filled = df_missing.replace(np.nan, 2)

In [156]: df_filled

Out[156]:

0 1 2

0 1.0 2.0 2.0

1 2.0 1.0 2.0

2 2.0 2.0 1.0

傳遞清單可替換多個值。

In [157]: df_filled.replace([1, 44], [2, 28])

Out[157]:

0 1 2

0 2.0 2.0 2.0

1 2.0 2.0 2.0

2 2.0 2.0 2.0

使用對應字典替換。

In [158]: df_filled.replace({1: 44, 2: 28})

Out[158]:

0 1 2

0 44.0 28.0 28.0

1 28.0 44.0 28.0

2 28.0 28.0 44.0

正規表示式替換#

注意

以 r 字元為字首的 Python 字串,例如 r'hello world' 是 “原始” 字串。它們對於反斜線的語意與沒有此字首的字串不同。原始字串中的反斜線會被解釋為跳脫反斜線,例如 r'\' == '\\'。

將 ‘.’ 替換為 NaN

In [159]: d = {"a": list(range(4)), "b": list("ab.."), "c": ["a", "b", np.nan, "d"]}

In [160]: df = pd.DataFrame(d)

In [161]: df.replace(".", np.nan)

Out[161]:

a b c

0 0 a a

1 1 b b

2 2 NaN NaN

3 3 NaN d

將 ‘.’ 替換為 NaN,並使用正規表示式移除周圍空白

In [162]: df.replace(r"\s*\.\s*", np.nan, regex=True)

Out[162]:

a b c

0 0 a a

1 1 b b

2 2 NaN NaN

3 3 NaN d

使用正規表示式清單替換。

In [163]: df.replace([r"\.", r"(a)"], ["dot", r"\1stuff"], regex=True)

Out[163]:

a b c

0 0 astuff astuff

1 1 b b

2 2 dot NaN

3 3 dot d

使用對應字典中的正規表示式替換。

In [164]: df.replace({"b": r"\s*\.\s*"}, {"b": np.nan}, regex=True)

Out[164]:

a b c

0 0 a a

1 1 b b

2 2 NaN NaN

3 3 NaN d

傳遞使用 regex 關鍵字的正規表達式巢狀字典。

In [165]: df.replace({"b": {"b": r""}}, regex=True)

Out[165]:

a b c

0 0 a a

1 1 b

2 2 . NaN

3 3 . d

In [166]: df.replace(regex={"b": {r"\s*\.\s*": np.nan}})

Out[166]:

a b c

0 0 a a

1 1 b b

2 2 NaN NaN

3 3 NaN d

In [167]: df.replace({"b": r"\s*(\.)\s*"}, {"b": r"\1ty"}, regex=True)

Out[167]:

a b c

0 0 a a

1 1 b b

2 2 .ty NaN

3 3 .ty d

傳遞正規表達式清單,它會以純量取代符合的項目。

In [168]: df.replace([r"\s*\.\s*", r"a|b"], "placeholder", regex=True)

Out[168]:

a b c

0 0 placeholder placeholder

1 1 placeholder placeholder

2 2 placeholder NaN

3 3 placeholder d

所有正規表達式範例也可以傳遞 to_replace 參數,作為 regex 參數。在此情況下,value 參數必須明確傳遞名稱,或 regex 必須是巢狀字典。

In [169]: df.replace(regex=[r"\s*\.\s*", r"a|b"], value="placeholder")

Out[169]:

a b c

0 0 placeholder placeholder

1 1 placeholder placeholder

2 2 placeholder NaN

3 3 placeholder d

注意

來自 re.compile 的正規表達式物件也是有效的輸入。